Microsoft zaprezentował sieć neuronową Kosmos-1, która jako dane wejściowe łączy tekst, obrazy, treści audio i wideo.

Naukowcy nazywają system „multimodalnym wielkim modelem językowym”. Według nich, takie algorytmy będą stanowiły podstawę ogólnej inteligencji (AGI), która będzie w stanie wykonywać zadania na poziomie człowieka. Badacze stwierdzili:

„Jako podstawowy element inteligencji, multimodalna percepcja jest niezbędna do osiągnięcia AGI w zakresie nabywania wiedzy i powiązania ze światem rzeczywistym

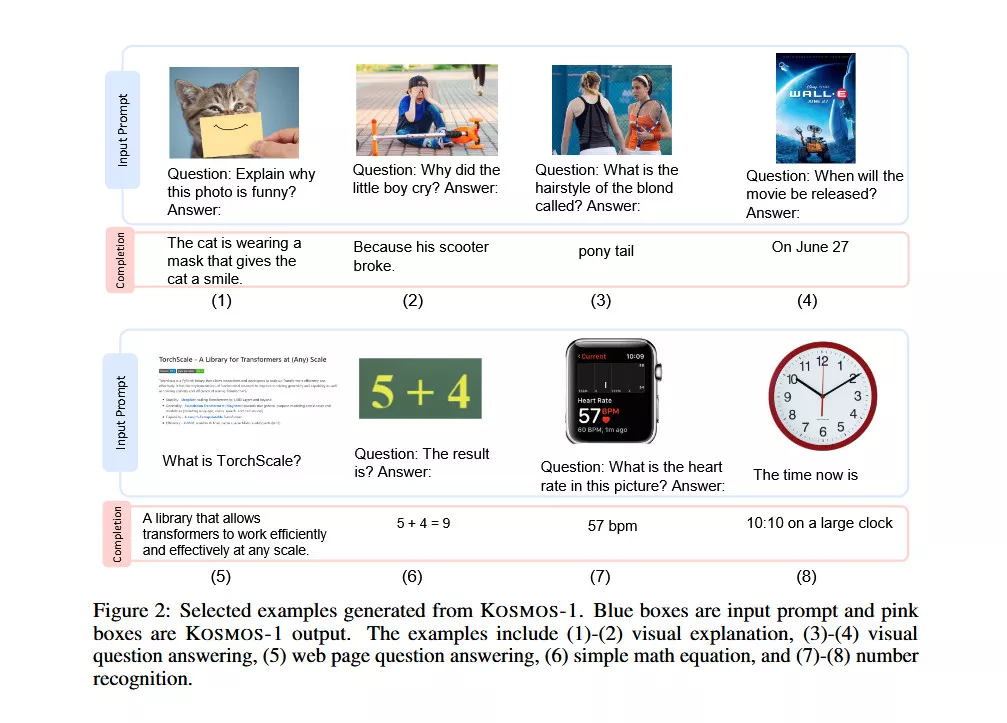

Według przykładów zawartych w pracy, Kosmos-1 może:

- analizować obrazy i odpowiadać na pytania na ich temat;

- odczytywać tekst z obrazów;

- tworzyć podpisy do obrazów;

- wykonać wizualny test IQ z dokładnością 22-26%.

Microsoft wytrenował Kosmos-1 na danych z Internetu, w tym na 800 GB anglojęzycznym zasobie tekstowym The Pile i archiwum internetowym Common Crawl. Po treningu badacze oceniali zdolności modelu w kilku testach:

- rozumienia i generowania języka;

- klasyfikacja tekstu bez optycznego rozpoznawania znaków;

- podpisywanie obrazów;

- wizualne odpowiedzi na pytania;

- odpowiadanie na pytania na stronie internetowej;

- klasyfikacja obrazów bez zdjęć.

Według Microsoftu, Kosmos-1 przewyższył obecne modele w wielu z tych testów. Badacze planują wkrótce opublikować kod źródłowy projektu na GitHubie.

Przypomnijmy, że w styczniu Microsoft ujawnił symulator ludzkiego głosu oparty na krótkiej próbce VALL-E.