Nvidia na konferencji GTC 2022 zaprezentowała procesory do przetwarzania zadań związanych ze sztuczną inteligencją, a także szereg usług dla deweloperów.

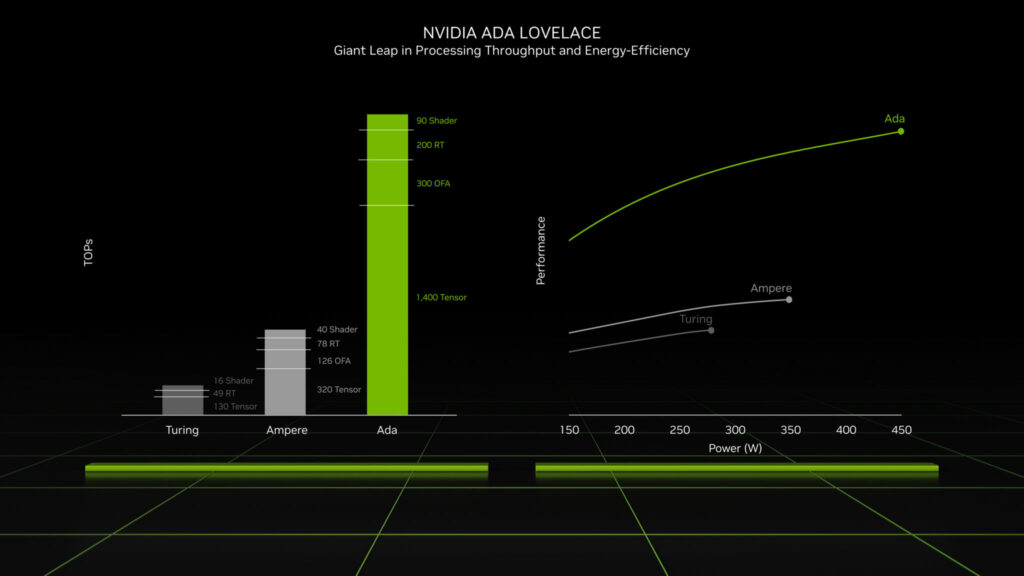

CEO firmy Techgiant, Jensen Huang, zademonstrował nową generację kart graficznych z serii GeForce RTX 40. Akceleratory oparte są na architekturze Ada Lovelace i reprezentowane są przez dwa modele: RTX 4090 i RTX 4080 w dwóch modyfikacjach pamięci.

Chipy produkowane są w procesie 4nm i zawierają do 76 miliardów tranzystorów. Kluczowe cechy nowej architektury to trzecia generacja rdzeni RT i czwarta generacja rdzeni tensorowych.

Karta graficzna GeForce RTX 4090 posiada 24 GB pamięci GDDR6X. Według Huanga, akcelerator zawiera 16 384 rdzenie CUDA i jest czterokrotnie wydajniejszy od RTX 3090.

Do sprzedaży trafi 12 października w cenie 1 599 dolarów.

GeForce RTX 4080 16GB posiada 9728 rdzeni CUDA. Mniejsza wersja 12 GB dysponuje 7 680 rdzeniami CUDA.

Obie karty graficzne trafią do sprzedaży w listopadzie w cenie odpowiednio 1199 i 899 dolarów.

Nowy algorytm

Firma Huang zapowiedziała nową wersję upscalera gier DLSS 3 AI. Według niego, w niektórych projektach algorytm czterokrotnie zwiększa FPS bez utraty jakości i płynności obrazu. DLSS 3 będzie dostępny tylko na kartach GeForce RTX z serii 40.

Huang zapowiedział także rozpoczęcie masowej produkcji serwerowych układów Nvidia H100. Według niego, nowe akceleratory są 3,5 razy bardziej wydajne od swoich poprzedników. Pozwala to na obniżenie kosztów posiadania serwerów, zmniejszenie liczby węzłów przy zachowaniu poziomu wydajności AI.

Pojazdy autonomiczne

Szef firmy zapowiedział Drive Thor System on Chip (SoC) dla pojazdów autonomicznych. Według zapowiedzi platforma dostarczy 2000 teraflopsów wydajności.

Pierwsze samochody na SoC Drive Thor nie pojawią się wcześniej niż w 2025 roku.

Platforma usługowa

Nvidia zapowiedziała platformę usługową do tworzenia dużych modeli językowych. NeMo LLM służy do generowania i streszczania tekstu, natomiast BioNeMo LLM do przewidywania struktury białek, opracowywania leków i innych badań medycznych.

Firma odsłoniła także własną platformę Omniverse Cloud Services do tworzenia i utrzymywania aplikacji z zakresu sztucznej inteligencji i metaverse. Usługa obejmuje:

- Omniverse Nucleus Cloud – platforma do tworzenia obiektów i scen 3D;

- Omniverse App Streaming – usługa strumieniowania aplikacji wykorzystujących akceleratory RTX;

- Omniverse Replicator – generator danych syntetycznych;

- Omniverse Farm – platforma do uruchamiania wielu instancji chmury;

- NVIDIA Isaac Sim, aplikacja do symulacji robotyki i generowania danych syntetycznych;

- NVIDIA DRIVE Sim™ – platforma do przeprowadzania symulacji pojazdów autonomicznych.

Wiele usług platformy chmury jest już dostępnych dla użytkowników.

Przypomnijmy, że w marcu Nvidia zaprezentowała nową generację serwerowych układów AI H100 oraz Grace CPU Superchip.

W kwietniu gigant technologiczny zapowiedział wykorzystanie sztucznej inteligencji do rozwoju procesorów graficznych.

We wrześniu rząd USA ograniczył eksport chipów Nvidia H100 do Rosji i Chin.